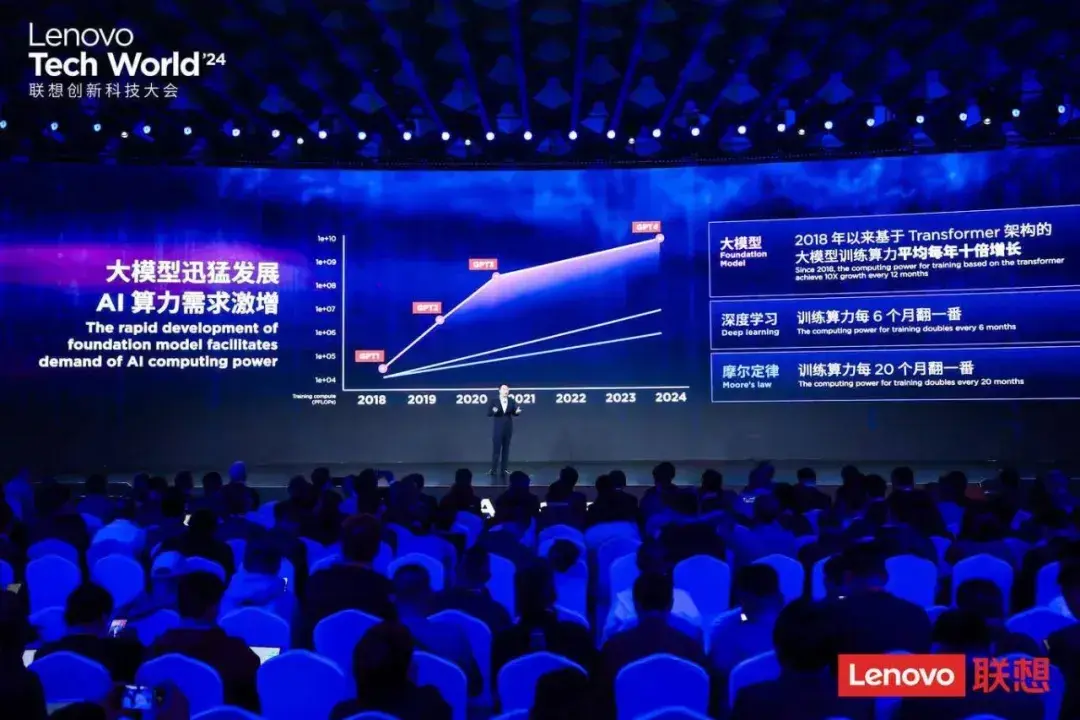

从2023年的chatgpt,到2024年的sora,ai和大模型正以不可思议的发展速度颠覆着业界的认知,但大模型的火热登场,也进一步引爆了智能算力的需求。传统算力时代,算力需求每18-20个月翻一倍,在深度学习出现之后,算力需求每6个月翻一倍,而到了大模型时代,对智能算力的需求几乎是每年数百倍的增长。

根据中国信通院发布的《中国算力发展指数白皮书(2023年)》显示,在目前的算力规模中,通用算力规模占比达74%,智能算力规模占比达25%,同比增加60%,成为当前算力快速增长的驱动力,而预计未来几年,智能算力的需求将比当前呈现上百倍的增长。

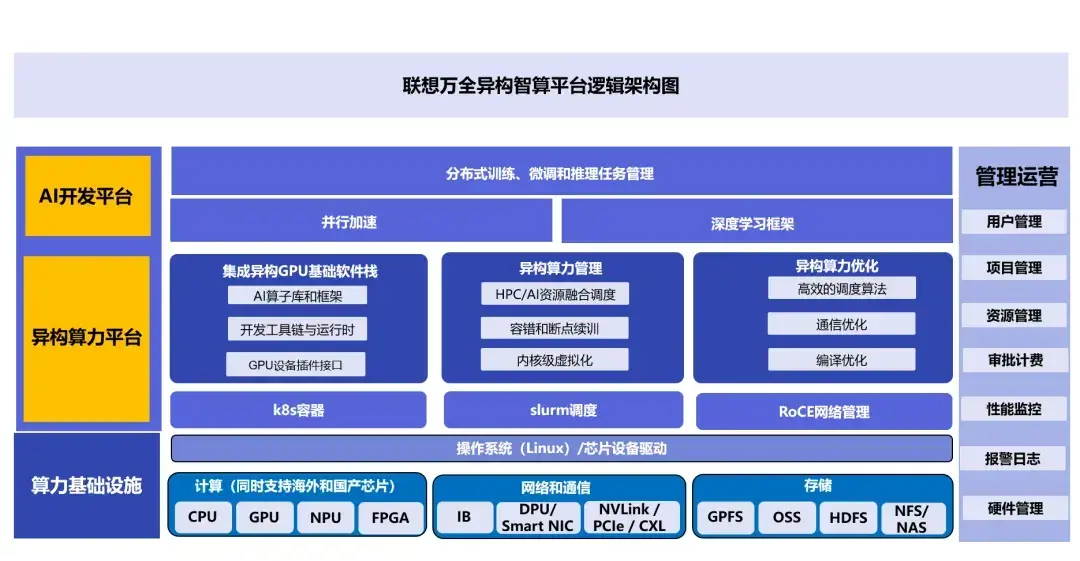

但新的难题也由此产生,在智能算力的1.0时代,主要是采用垂直一体式的方案,针对性地满足高性能计算、人工智能、大数据计算等不同的应用负载,通用性和兼容性比较低;而在智能算力的2.0时代,则出现了异构智算融合的趋势,即将不同架构的芯片平台、不同的算法模型以及数据集最大化融合,让用户可以根据业务场景和计算任务选择最适合的算力方案。在这样的背景下,如何把智能算力的效率发挥到极致,如何提升数据中心的整体能效,让智能算力的价值得到最大化体现呢?

在日前举办的联想创新科技大会(2024 lenovo tech world)上,联想正式发布联想万全异构智算平台,该平台集成了联想为满足ai应用大潮所打造的五大创新技术,可以说为ai时代大模型训练和推理构建出了稳定高效的基础设施算力底座,也让智能算力能够真正“用得上”、“用得好”、“用得精”。

与此同时,联想还与中国智能计算产业联盟共同宣布,发起成立异构智算产业生态联盟,联合产业头部生态伙伴共建联想万全生态,助力中国智算生态繁荣发展与创新。

毫无疑问,站在ai产业大变革的今天,联想基于自身在数据中心基础设施的持续的创新和投入,以及最佳实践和经验,推出联想万全异构智算平台,并发起成立异构智算产业生态联盟,相信这将会进一步释放出异构智算的“乘数效应”,为千行百业创造出更多具有想象空间的新业态、新服务和新模式,激发更大的新质生产力。

跨越智能算力“四座大山”

随着大模型时代的到来,可以发现智能算力与产业的融合正变得越来越紧密,从智慧医疗,智慧金融,智慧城市再到无人驾驶等等,智能算力已经开始渗透到千行百业的方方面面,推动着“算力基建化”的步伐。

也正因此,去年底国家六部门联合印发的《算力基础设施高质量发展行动计划》中,就提出到2025年,计算力方面,算力规模超过300 eflops,其中智能算力占比要达到35%,这也代表着我国的算力产业步入了高速发展的新阶段,智能算力更成为了数字经济“主航道”中最为核心的驱动力。

联想集团副总裁、中国基础设施业务群总经理陈振宽

在联想集团副总裁、中国基础设施业务群总经理陈振宽看来,智能算力的火爆背后,同样也为数据中心基础设施带来了诸多的挑战,主要体现在以下几个方面:

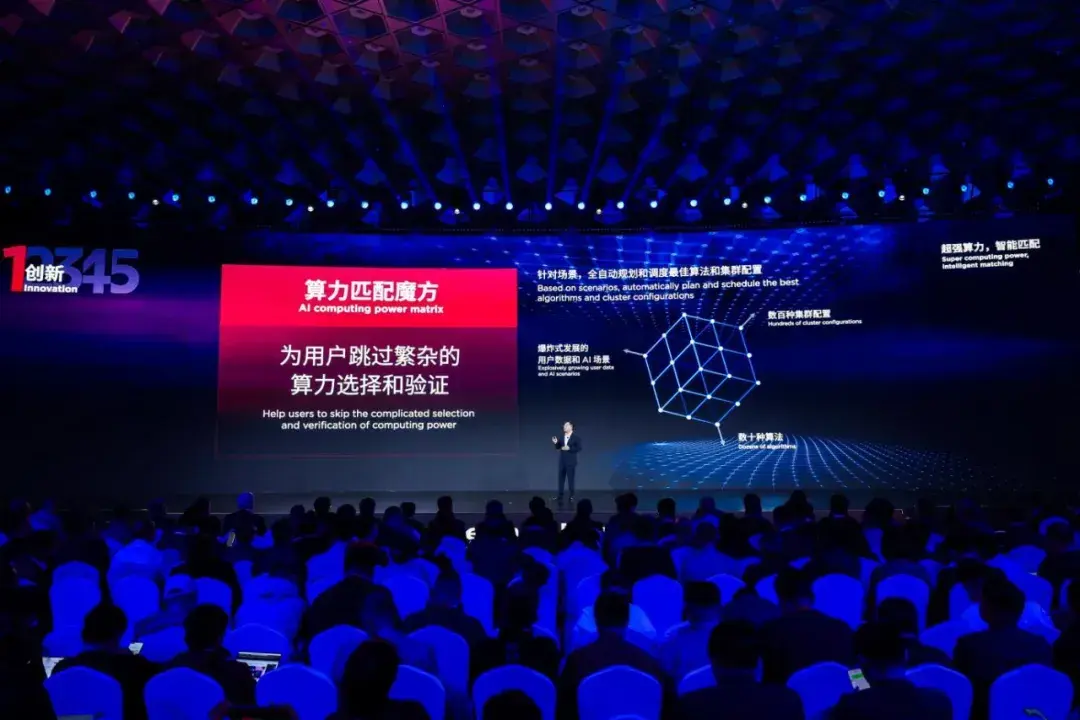

挑战一,场景日益丰富,算力复杂多元,如何选择和匹配合适的算力?目前已经有五种以上主流算法框架和十种以上算子库来支持不同的应用场景。同时,不同类型的gpu、服务器、存储和网络组成了上百种不同的集群配置,特别是场景、算法和集群之间的选择和验证,不但技术繁杂而且周期长,这都给用户带来了极大的压力。

挑战二,从千卡到万卡,如何减少故障恢复时间,提升集群的可用性?以千卡训练集群为例,目前千卡集群每月至少有15次的故障断点,在常规的断点续训手段下,每次恢复训练需要几个小时,产生的额外费用超过百万元,而随着ai集群规模从千卡到万卡,故障中断次数及恢复所需时间呈指数级增长。

挑战三,智能算力基础设施的建设成本极高,如何改善和最大化ai算力利用率?ai对算力的需求是无穷尽的,然而随着集群集成的芯片越来越多,我们不得不应对算法效率不高、计算资源不足、互联带宽受限等众多技术挑战。数据显示,当前业内mfu(模型算力利用率)普遍在30%左右,顶尖的集群利用率也只能做到50%,因此这就需要行业突破和解决gpu卡利用率、集群通讯效率、ai故障恢复、算法匹配度等系统性问题。

挑战四,在“双碳”政策的驱动下,如何最大化提升数据中心的整体能效?一直以来,数据中心作为“能耗大户”,其建设和发展过程中也带来了巨大的能耗挑战。特别是在当前算力升级带来的能耗“飙升”的情况下,如何通过先进的散热技术,突破芯片在系统中的散热瓶颈,同时提升能效,降低数据中心pue将“刻不容缓”。

由此可见,由大模型兴起所产生的巨量算力需求让本就供需不平的算力产业结构进一步“承压”,特别是如何跨越智能算力面临的“四座大山”已成为整个业界的新挑战和新课题。

夯实大模型时代“算力底座”

也正是洞察到这种变化和痛点,联想正式发布集五大技术创新为一体的联想万全异构智算平台,该平台可帮助行业用户跨越智能算力面临的重重挑战,真正让千行百业在智能算力时代“用得上”、“用得好”、“用得精”,具体来看:

针对算力匹配方面,当下异构智算融合已是大势所趋,一是cpu,gpu,dpu,npu等处理器的异构;二是ai算力集群,科学计算集群和通用计算集群的异构,唯有做好异构算力协同工作,才能有效支持复杂计算任务所需要的综合计算。

而联想万全异构智算平台搭载的“多维智能算力匹配魔方”技术,构建了ai场景与算法与集群硬件三者匹配关系的算力魔方知识库,可标识ai场景、算法、集群配置这三者的匹配关系。更重要的是,“算力匹配魔方”可针对不同场景,可以全自动规划和调度最佳算法和集群配置,用户只需输入场景和数据,即可自动加载最优算法和调度最佳集群配置,由此为用户跳过繁杂的算力选择和验证。

提升算力利用率和可用性方面,在ai基础设施中,要提高计算效率有两大关键要素: 一是提升算力的利用率,二是让算力持续可用。因此,在联想万全异构智算平台五大创新技术中,有四项都是聚焦在了提升算力利用率和可用性的算法创新上。

其中,gpu内核态虚拟化算法技术,由联想研究院开发的gpu驱动层的内核态虚拟化算法,可最大化挖掘处理器潜力,让vgpu利用率从80%提升到95%;此外,联想集合通信算法库技术,能够自动感知集群网络拓扑,并选择和采用经联想增强的集合通信算法使数据传输在最佳路径。以千卡规模集群为例,采用集成了联想集合通信库的联想万全异构智算平台做管理调度,可使网络通信效率提升超10%,并且集群规模越大,效果越显著;而ai高效断点续训技术,其核心能力是“以ai预测ai”训练故障,在断点前针对故障特征做优化备份,在断点后可极速恢复。以千卡训练集群为例,目前联想能将断点续训恢复时间缩减到分钟级,不仅能够大幅提升训练效率,还可以帮助用户节省额外支出百万元/月。

针对集群的调度管理,联想万全异构智算平台内置了ai与hpc异构集群超级调度器,这是破局算力孤岛,打开集群共享之门的“关键钥匙”,该“调度器”最为精髓之处就是做出能指挥双类型调度的最精简架构,在ai的k8s调度和hpc的slurm调度之上,通过切换“语言”的方式分别指挥ai和hpc调度器,1小时内自动完成跨集群的资源调度和共享,使得用户可以充分利用基础设施的每一分算力。

而面向未来,联想也将挑战超过万卡规模集群的通讯算法优化,挑战秒级的断点续训,深入研究相变式液冷技术,布局模块化液冷数据中心,而这些核心技术创新,也将助力ai算力朝着更强大、更稳定、更高效和更绿色的方向高质量发展。

客观地说,当前业界各种智算平台已经对异构算力的管理和调度开展了不同技术方向的探索,市场上有些不同的异构智算管理平台,但联想万全异构智算平台仍有三个独特的优势:

得益于联想在智算和超算领域的长期耕耘,其ai与hpc异构集群超级调度器属于业内首创,是联想在异构智算领域打造的“独门秘籍”; 同时,联想分钟级断点续训的故障预测机制,同样也是历经多年研发的,是分钟级断点续训能够实现的关键技术,同样在业界是“独一无二”的;不仅如此,相比市场上的其他异构管理平台,联想万全异构智算平台纳管丰富的多的异构生态,和提供更深入全面的集群管理,这些关键技术的创新都为夯实大模型时代的“算力底座”提供了坚实的基础,背后也体现出了三重全新的价值。

一是,用得上,指的是联想万全异构智算平台将算力管理与调度,数据治理与模型优化、训练精调和推理应用开发等多层次的能力实现了全面集成,能够向下纳管丰富的算力生态,向上对接为各类场景优化的模型及ai工具集,因此可为用户提供更简单、更高效、更稳定的算力体验。

二是,用得好,如果我们从用户视角出发来看,不论是模型开发,推理服务开发,还是ai应用开发,计算效率就是业务的根基,高效计算才能让ai应用的迭代部署跟上市场需求,才能控制业务tco成本使ai创作的投入产出合理化。为此,联想万全异构智算平台始终将突破计算效率的瓶颈作为平台持续追求的差异化价值。无论是gpu内核态虚拟化算法技术、联想集合通信算法库技术还是异构集群超级调度器等,核心都是最大化提升用户的算力利用率和可用性,让用户“用得好”ai算力。

三是,用得精,则是联想万全异构智算平台不但打造了一个能够高度自动化完成ai全流程开发的平台,同时也是可输出高可用算力并不断突破计算效率瓶颈的利器,借助这个平台,行业用户可自动完成ai计算并发布模型或发布推理服务。同时,平台也为专业的ai开发用户留有手动深入调整计算过程的空间,包括工具和模型的选择,算力配置的调整,对任务的定制化监控等,这样就能使得每种资源都能在最适合的任务上发挥最大效能,真正让用户可以更加“精细化”管理ai算力资源,进一步实现“降本增效”的价值。

释放异构智算“乘数效应”

值得一提的是,在本次联想创新科技大会2024上,联想还与中国智能计算产业联盟共同宣布,发起成立异构智算产业生态联盟。据了解,异构智算产业生态联盟框架由ai芯片层、ai设备与系统层和ai平台与应用层,能够实现从iaas平台、ai训练与推理到行业场景凯发k8一触即发的解决方案的全覆盖。